全景分割(Panoptic Segmentation)(CVPR 2019)

- 摘要

- 1. 导言

- 2. 相关工作

- 3. 全景分割格式

- 4. 全景分割度量

-

- 4.1 片段匹配

- 4.2 PQ计算

- 4.3 与现有度量的比较

- 5. 全景分割数据集

- 6. 人类一致性研究

- 7. 机器性能基线

- 8. 全景分割的未来

- References

声明:此翻译仅为个人学习记录

文章信息

- 标题:Panoptic Segmentation (CVPR 2019)

- 作者:Alexander Kirillov、Kaiming He、Ross Girshick、Carsten Rother、Piotr Dollár

- 文章链接:https://arxiv.org/pdf/1801.00868.pdf

摘要

我们提出并研究了一个称为全景分割(PS)的任务。全景分割统一了语义分割(为每个像素分配类标签)和实例分割(检测和分割每个对象实例)的典型不同任务。提出的任务需要生成丰富和完整的相干场景分割,这是迈向真实世界视觉系统的重要一步。虽然计算机视觉的早期工作涉及相关的图像/场景解析任务,但这些任务目前并不流行,可能是由于缺乏适当的度量或相关的识别挑战。为了解决这个问题,我们提出了一种新的全景质量(PQ)度量,它以可解释和统一的方式捕获所有类(stuff和things)的性能。使用提出的度量,我们在三个现有数据集上对PS的人和机器性能进行了严格研究,揭示了关于任务的有趣见解。我们工作的目的是在更统一的图像分割视图中恢复社区的兴趣。有关更多分析和最新结果,请查看本文的arXiv版本:https://arxiv.org/abs/1801.00868

1. 导言

在计算机视觉的早期,things(事物)——人、动物、工具等可数物体——受到了主要的关注。Adelson[1]质疑这一趋势是否明智,并强调了研究识别stuff(物体)——具有类似纹理或材料的无定形区域,如草地、天空和道路——的系统的重要性。stuff和things之间的这种二分法一直持续到今天,这反映在视觉识别任务的划分以及为stuff和thing任务开发的专门算法中。

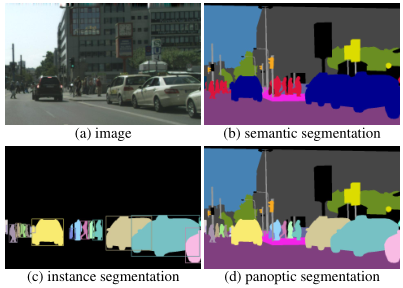

研究stuff通常被描述为一项称为语义分割的任务,见图1b。由于stuff是无定形且不可数的,所以这个任务被定义为简单地为图像中的每个像素分配一个类标签(请注意,语义分割将thing类视为stuff)。相反,研究things通常被表述为目标检测或实例分割的任务,其目标是检测每个目标,并分别用边界框或分割掩码对其进行描绘,见图1c。这两个视觉识别任务的数据集、细节和度量虽然看似相关,但差异很大。

语义和实例分割之间的分裂导致了这些任务的方法上的平行裂痕。stuff分类器通常建立在具有扩张[51,5]的完全卷积网络[30]上,而目标检测器通常使用目标提议[15],并且基于区域[37,14]。在过去十年中,这些任务的整体算法进展令人难以置信,然而,孤立地关注这些任务可能会忽略一些重要的事情。

一个自然而然的问题出现了:stuff和things之间是否能够调和?生成丰富和连贯的场景分割的统一视觉系统的最有效设计是什么?考虑到这些问题在现实应用中的相关性,如自动驾驶或增强现实,这些问题尤为重要。

图1:对于给定的(a)图像,我们展示了真值:(b)语义分割(每像素类标签),(c)实例分割(每对象掩码和类标签),以及(d)提出的全景分割任务(每像素类别+实例标签)。PS任务:(1)包含stuff和thing类,(2)使用简单但通用的格式,以及(3)为所有类引入统一的评估度量。全景分割概括了语义和实例分割,我们预计统一任务将带来新的挑战,并支持创新的新方法。

有趣的是,虽然语义和实例分割主导了当前的工作,但在前深度学习时代,人们对使用各种名称描述的联合任务感兴趣,如场景解析[42]、图像解析[43]或整体场景理解[50]。尽管这一总体方向具有实际意义,但目前并不流行,可能是由于缺乏适当的度量或识别挑战。

在我们的工作中,我们的目标是恢复这一方向。我们提出了一个任务:(1)包含stuff和thing类,(2)使用简单但通用的输出格式,以及(3)引入统一的评估度量。为了清楚地消除先前工作的歧义,我们将生成的任务称为全景分割(PS)。“全景”的定义是“包括在一个视图中可见的一切”,在我们的上下文中,“全景”指的是一个统一的全局分割视图。

我们用于全景分割的任务格式很简单:必须为图像的每个像素分配语义标签和实例id。具有相同标签和id的像素属于同一对象;对于stuff标签,实例id将被忽略。如图1d所示。这种格式以前已经被采用,特别是通过产生非重叠实例分割的方法[18、28、2]。我们把它用于我们的联合任务,包括stuff和things。

全景分割的一个基本方面是用于评估的任务度量。虽然许多现有的度量对于语义或实例分割都很流行,但这些度量最适合分别用于stuff或things,而不是两者。我们认为,不相交度量的使用是社区通常孤立地研究stuff和thing分割的主要原因之一。为了解决这一问题,我们在§4中引入了全景质量(PQ)度量。PQ简单且信息丰富,最重要的是,可用于以统一的方式测量stuff和things的性能。我们希望,拟议的联合指标将有助于更广泛地采用联合任务。

全景分割任务包括语义和实例分割,但引入了新的算法挑战。与语义分割不同,它需要区分单个目标实例;这对完全卷积网络提出了挑战。与实例分割不同,对象分割必须不重叠;这对独立操作每个目标的基于区域的方法提出了挑战。生成相干图像分割来解决stuff和things之间的不一致性,这是走向现实世界的重要一步。

由于PS的真值和算法格式必须采用相同的形式,我们可以对全景分割中的人类一致性进行详细研究。这使我们能够更详细地理解PQ度量,包括识别与分割以及stuff与things性能的详细分类。此外,测量人体PQ有助于我们理解机器性能。这很重要,因为它将允许我们监控PS的各种数据集的性能饱和。

最后,我们对PS的机器性能进行了初步研究。为此,我们定义了一个简单且可能是次优的启发式算法,该算法通过一系列后处理步骤将两个独立系统的输出合并起来,用于语义和实例分割(本质上是一种复杂的非最大抑制形式)。我们的启发式方法为PS建立了一个基线,并为我们提供了对其提出的主要算法挑战的洞察。

我们在三个流行的分割数据集上研究了人和机器的性能,这三个数据集都有stuff与things注释。这包括Cityscapes [6]、ADE20k[54]和Mapillary Vistas [35]数据集。对于每个数据集,我们直接从挑战组织者处获得了最先进方法的结果。在未来,我们将把我们的分析扩展到COCO[25],在COCO[25]上对stuff进行注释[4]。我们在这些数据集上的结果为研究全景分割的人和机器性能奠定了坚实的基础。

COCO[25]和Mapillary Vistas[35]都将全景分割任务作为2018年ECCV识别挑战中的一个轨道。我们希望,在这些流行的识别数据集上,将PS与实例和语义分割轨道放在一起,将有助于更广泛地采用拟议的联合任务。

2. 相关工作

在计算机视觉的整个历史中,新的数据集和任务扮演了关键角色。它们有助于促进我们领域的进步和实现突破,同样重要的是,它们有助我们衡量和认识我们社区正在取得的进展。例如,ImageNet[38]有助于推动视觉识别深度学习技术的最近普及[20],并举例说明了数据集和任务可能具有的潜在转换能力。我们引入全景分割任务的目标类似:挑战我们的社区,推动新方向的研究,并实现预期和意外的创新。接下来我们将回顾相关任务。

目标检测任务。早期使用ad-hoc数据集进行人脸检测的工作(例如[44,46])有助于推广边界框目标检测。后来,pedestrian detection数据集[8]帮助推动了该领域的进展。PASCAL VOC数据集[9]将任务升级为一组更具挑战性的图像上的更多样的通用目标类。最近,COCO数据集[25]将检测推向了实例分割的任务。通过构建这项任务并提供高质量数据集,COCO帮助定义了一个新的、令人兴奋的研究方向,并在实例分割方面取得了许多近期突破[36、24、14]。我们的全景分割的一般目标是相似的。

语义分割任务。语义分割数据集具有丰富的历史[39,26,9],并有助于推动关键创新(例如,使用[26,9]开发了完全卷积网络[30])。这些数据集包含stuff和thing类,但不区分单个目标实例。最近,该领域出现了许多新的分割数据集,包括Cityscapes [6]、ADE20k[54]和Mapillary Vistas [35]。这些数据集实际上支持语义和实例分割,并且每个数据集都选择为这两个任务提供单独的跟踪。重要的是,它们包含PS所需的所有信息。换句话说,全景分割任务可以在这些数据集上引导,而无需任何新的数据收集。

多任务学习。随着深度学习在许多视觉识别任务中的成功,人们对多任务学习方法产生了浓厚的兴趣,这些方法具有广泛的能力,可以在单个框架中解决多个不同的视觉问题[19、32、34]。例如,UberNet[19]使用单个网络解决多个低到高级别的视觉任务,包括目标检测和语义分割。虽然在这一领域有很大的兴趣,但我们强调全景分割不是一个多任务问题,而是图像分割的一个单一、统一的视图。具体而言,多任务设置允许独立且可能不一致的stuff和things输出,而PS需要单个相干场景分割。

联合分割任务。在前深度学习时代,人们对生成连贯的场景解释产生了浓厚的兴趣。图像解析方面的开创性工作[43]提出了一个通用贝叶斯框架,用于联合建模分割、检测和识别。后来,基于图形模型的方法研究了一致的stuff和thing分割[50、41、42、40]。虽然这些方法有一个共同的动机,但没有商定的任务定义,使用了不同的输出格式和不同的评估指标,包括用于评估stuff和thing类结果的单独指标。近年来,这一方向变得不那么受欢迎,可能是因为这些原因。

在我们的工作中,我们的目标是恢复这一总体方向,但与之前的工作不同,我们专注于任务本身。具体来说,如前所述,PS:(1)同时处理stuff和thing类,(2)使用简单格式,以及(3)为stuff与thing引入统一度量。以前关于联合分割的工作使用不同的格式和不相交的度量来评估stuff和things。生成非重叠实例分割的方法[18、3、28、2]使用与PS相同的格式,但这些方法通常只处理thing类。通过使用简单的格式处理stuff和things,并引入统一的度量标准,我们希望鼓励更广泛地采用联合任务。

3. 全景分割格式

任务格式。全景分割的格式易于定义。给定由

L

L

L个语义类的预定集合编码为

L

:

=

{

,

…

,

L

−

1

}

\mathcal L:=\{0,…,L-1\}

L:={0,…,L−1},该任务需要全景分割算法将图像的每个像素

i

i

i映射到一对

(

l

i

,

z

i

)

∈

L

×

N

(l_i,z_i )∈L×N

(li,zi)∈L×N,其中

l

i

l_i

li表示像素i的语义类,

z

i

z_i

zi表示其实例id。

z

i

z_i

zi将同一类的像素分组为不同的片段。真值注释编码相同。模糊或类外像素可以被分配特殊的空标签;即,并非所有像素都必须具有语义标签。

stuff和thing标签。语义标签集由子集

L

S

t

\mathcal L^{S_t }

LSt和

L

T

h

\mathcal L^{T_h }

LTh组成,使得

L

=

L

S

t

∪

L

T

h

\mathcal L=\mathcal L^{S_t } \cup \mathcal L^{T_h }

L=LSt∪LTh和

L

S

t

∩

L

T

h

=

∅

\mathcal L^{S_t } \cap \mathcal L^{T_h }=∅

LSt∩LTh=∅。这些子集分别对应于stuff与thing标签。当像素被标记为

l

i

∈

L

S

t

l_i∈\mathcal L^{S_t }

li∈LSt时,其对应的实例id

z

i

z_i

zi是无关的。也就是说,对于stuff类,所有像素都属于同一实例(例如,同一天空)。否则,具有相同

(

l

i

,

z

i

)

(l_i,z_i )

(li,zi)赋值的所有像素,其中

l

i

∈

L

T

h

l_i∈\mathcal L^{T_h }

li∈LTh,属于同一实例(例如,同一辆车),相反,属于单个实例的所有像素必须具有相同的

(

l

i

,

z

i

)

(l_i,z_i )

(li,zi)。与以前的数据集一样,选择哪些类是stuff和things是留给数据集创建者的设计选择。

与语义分割的关系。PS任务格式是语义分割格式的严格概括。事实上,这两项任务都需要为图像中的每个像素分配一个语义标签。如果真值没有指定实例,或者所有类都是stuff,那么任务格式是相同的(尽管任务度量不同)。此外,包含thing类,其每个图像可能有多个实例,可以区分任务。

与实例分割的关系。实例分割任务需要一种方法来分割图像中的每个目标实例。然而,它允许重叠片段,而全景分割任务只允许为每个像素分配一个语义标签和一个实例id。因此,对于PS,通过构造不可能出现重叠。在下一节中,我们将说明这种差异在性能评估中起着重要作用。

置信度得分。与语义分割类似,但与实例分割不同,我们不需要与PS的每个片段相关的置信度分数。这使得全景任务相对于人和机器对称:两者必须生成相同类型的图像注释。它还使得评估PS的人类一致性变得简单。这与实例分割形成对比,实例分割不容易进行此类研究,因为人类注释器不提供明确的置信度得分(尽管可以测量单个准确/召回点)。我们注意到,置信度得分为下游系统提供了更多的信息,这可能是有用的,因此在某些设置下,仍然需要PS算法生成置信度得分。

4. 全景分割度量

在本节中,我们将介绍一种新的全景分割度量。我们首先注意到,现有的度量是专门用于语义或实例分割的,不能用于评估同时涉及stuff和thing类的联合任务。以前关于联合分割的工作通过使用独立的度量(例如[50,41,42,40])来评估stuff和thing的性能,从而回避了这个问题。然而,这给算法开发带来了挑战,使比较变得更加困难,并阻碍了交流。我们希望引入一个统一的stuff和things度量标准将鼓励对统一任务的研究。

在进一步讨论细节之前,我们首先确定PS的合适度量的以下需求:

完整性。度量应该以统一的方式处理stuff和thing类,捕获任务的所有方面。

可解释性。我们寻求具有可识别意义的指标,以便于沟通和理解。

简单。此外,度量应该易于定义和实现。这提高了透明度并便于重新实现。与此相关的是,度量应该能够高效计算,以实现快速评估。

在这些原则的指导下,我们提出了一种新的全景质量(PQ)度量。PQ测量相对于真值的全景分割预测的质量。它包括两个步骤:(1)分片段匹配和(2)给定匹配的PQ计算。我们接下来描述每个步骤,然后返回到与现有度量的比较。

4.1 片段匹配

我们规定,只有当预测片段和真值片段的交并比(IoU)严格大于0.5时,它们才能匹配。这一要求与全景分割的非重叠特性一起给出了唯一的匹配:每个真值片段最多可以有一个预测片段匹配。

定理1. 给定图像的预测和真值全景分割,每个真值片段最多可以有一个对应的预测片段,IoU严格大于0.5,反之亦然。

证据 设

g

g

g为真值片段,

p

1

p_1

p1和

p

2

p_2

p2为两个预测片段。根据定义,

p

1

∩

p

2

=

∅

p_1∩p_2=∅

p1∩p2=∅(它们不重叠)。自

∣

p

i

∩

g

∣

≥

∣

g

∣

|p_i∩g|≥|g|

∣pi∩g∣≥∣g∣,我们得到以下结果:

I

o

U

(

p

i

,

g

)

=

∣

p

i

∩

g

∣

∣

p

i

∪

g

∣

≤

∣

p

i

∩

g

∣

∣

g

∣

f

o

r

i

∈

1

,

2

IoU(p_i,g)=\frac{|p_i∩g|}{|p_i∪g|} ≤ \frac{|p_i∩g|}{|g|} \quad for \ \ i∈{1,2}

IoU(pi,g)=∣pi∪g∣∣pi∩g∣≤∣g∣∣pi∩g∣for i∈1,2

对

i

i

i求和,自

∣

p

1

∩

g

∣

+

∣

p

2

∩

g

∣

≤

∣

g

∣

|p_1∩g|+|p_2∩g|≤|g|

∣p1∩g∣+∣p2∩g∣≤∣g∣由于

p

1

∩

p

2

=

∅

p_1∩p_2=∅

p1∩p2=∅这个事实,我们可得到

I

o

U

(

p

1

,

g

)

+

I

o

U

(

p

2

,

g

)

≤

∣

p

1

∩

g

∣

+

∣

p

2

∩

g

∣

∣

g

∣

≤

1

IoU(p_1,g)+IoU(p_2,g)≤\frac{|p_1∩g|+|p_2∩g|}{|g|} ≤1

IoU(p1,g)+IoU(p2,g)≤∣g∣∣p1∩g∣+∣p2∩g∣≤1

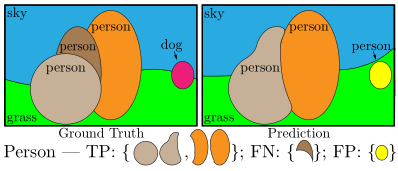

图2:真值和图像的预测全景分割的玩具插图。相同颜色的片段对的IoU大于0.5,因此匹配。我们展示了如何将person类的片段划分为真阳性TP、假阴性FN和假阳性FP。

因此,如果

I

o

U

(

p

1

,

g

)

≥

0.5

IoU(p_1,g)≥0.5

IoU(p1,g)≥0.5,则

I

o

U

(

p

2

,

g

)

IoU(p_2,g)

IoU(p2,g)必须小于0.5。颠倒

p

p

p和

g

g

g的作用可以用来证明只有一个真值片段,其可以具有预测片段严格大于0.5的IoU。

匹配必须具有IoU大于0.5的要求,这反过来产生了唯一匹配定理,实现了我们所需的两个属性。首先,它简单而有效,因为对应关系是唯一的,并且很容易获得。第二,它是可解释和易于理解的(并且不需要解决复杂的匹配问题,这通常是这些类型的度量[13,49])。

注意,由于唯一性属性,对于IoU>0.5,任何合理的匹配策略(包括贪婪和最优)都将产生相同的匹配。对于较小的IoU,将需要其他匹配技术;然而,在实验中,我们将表明较低的阈值是不必要的,因为IoU≤ 0.5的匹配在实践中是罕见的。

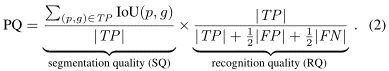

4.2 PQ计算

我们独立计算每个类的PQ,并在类上求平均值。这使得PQ对类不平衡不敏感。对于每个类别,唯一匹配将预测和真值片段分成三组:真阳性(TP)、假阳性(FP)和假阴性(FN),分别表示匹配的片段对、不匹配的预测片段和不匹配的真值片段。图2显示了一个示例。给定这三个集合,PQ定义为:

P

Q

=

∑

(

p

,

g

)

∈

T

P

I

o

U

(

p

,

g

)

∣

T

P

∣

+

1

2

∣

F

P

∣

+

1

2

∣

F

N

∣

PQ=\frac{∑_{(p,g)∈TP} IoU(p,g) }{|TP|+\frac{1}{2}|FP|+\frac{1}{2}|FN| }

PQ=∣TP∣+21∣FP∣+21∣FN∣∑(p,g)∈TPIoU(p,g)

检查后的

P

Q

PQ

PQ直观:

∑

(

p

,

g

)

∈

T

P

I

o

U

(

p

,

g

)

∑_{(p,g)∈TP} IoU(p,g)

∑(p,g)∈TPIoU(p,g) 只是匹配片段的平均IoU,而

1

2

∣

F

P

∣

+

1

2

∣

F

N

∣

\frac{1}{2}|FP|+\frac{1}{2}|FN|

21∣FP∣+21∣FN∣ 添加到分母以惩罚不匹配的片段。请注意,无论其面积如何,所有片段都具有同等的重要性。此外,如果我们将PQ乘除以TP集的大小,则PQ可以被视为分割质量(SQ)项和识别质量(RQ)项的乘积:

以这种方式编写,RQ是常见的F1分数[45],广泛用于检测设置中的质量估计[33]。SQ只是匹配片段的平均IoU。我们发现PQ=SQ×RQ的分解为分析提供了洞察。然而,我们注意到,这两个值不是独立的,因为SQ仅在匹配片段上测量。

我们对PQ的定义达到了我们的要求。它使用一个简单且可解释的公式以统一的方式测量所有类的性能。最后,我们讨论了如何处理空洞区域和实例组[25]。

空标签。真值中有两个空标签来源:(a)类外像素和(b)模糊或未知像素。由于我们通常无法区分这两种情况,因此我们不评估空像素的预测。具体而言:(1)在匹配过程中,从预测中移除在真值中标记为空的预测片段中的所有像素,并且不影响IoU计算;(2)在匹配之后,移除包含超过匹配阈值的空像素的一部分的未匹配预测片段,并且不计算为假阳性。最后,输出也可能包含空像素;这些不影响评估。

组标签。一种常见的注释实践[6,25]是,如果难以准确描述每个实例,则对同一语义类的相邻实例使用组标签而不是实例ID。为了计算PQ:(1)在匹配期间,不使用组区域,以及(2)在匹配之后,移除包含来自同一类别的组的超过匹配阈值的像素的一部分的未匹配预测片段,并且不计算为假阳性。

4.3 与现有度量的比较

我们通过将PQ与现有的语义和实例分割度量进行比较得出结论。

语义分割度量。语义分割的常用度量包括像素精度、平均精度和IoU[30]。这些度量仅基于像素输出/标签计算,完全忽略目标级标签。例如,IoU是正确预测的像素与每个类别的预测或真值中的像素总数之间的比率。由于这些度量忽略了实例标签,因此它们不太适合评估thing类。最后,请注意,语义分割的IoU与我们的分割质量(SQ)不同,后者计算为匹配片段上的平均IoU。

实例分割度量。例如,实例分割的标准度量是平均精度(AP)[25,13]。AP要求每个目标片段都有一个置信分数,以估计精度/召回曲线。请注意,尽管置信度分数对于目标检测非常自然,但它们不用于语义分割。因此,AP不能用于测量语义分割的输出,也不能用于测量PS的输出(另见§3中关于置信度的讨论)。

全景质量。PQ以统一的方式处理所有类(stuff和things)。我们注意到,虽然将PQ分解为SQ和RQ有助于解释结果,但PQ不是语义和实例分割度量的组合。相反,SQ和RQ是为每个类(stuff和things)计算的,分别测量分割和识别质量。因此,PQ统一了所有类别的评估。我们在§7中对PQ进行了严格的实验评估,包括在语义和实例分割方面分别与IoU和AP进行比较,以此支持这一主张。

5. 全景分割数据集

据我们所知,只有三个公共数据集具有密集的语义和实例分割注释:Cityscapes[6]、ADE20k[54]和Mapillary Vistas[35]。我们使用所有三个数据集进行全景分割。此外,在未来,我们将把我们的分析扩展到COCO[25],最近对其stuff进行了注释[4]。

Cityscapes[6]有5000张城市环境中以自我为中心的驾驶场景图像(2975 train、500 val和1525 test)。它具有19个类的密集像素注释(97%覆盖率),其中8个具有实例级分段。

ADE20k[54]有超过25k的图像(20k train、2k val、3k test),这些图像使用开放字典标签集进行密集注释。对于2017 Places Challenge,选择了覆盖所有像素89%的100个thing和50个stuff类。我们在学习中使用这个封闭词汇。

Mapillary Vistas[35]具有25k街景图像(18k train、2k val、5k test),分辨率范围广泛。数据集的“研究版”被密集注释(98%的像素覆盖率),有28个stuff类和37个thing类。

6. 人类一致性研究

全景分割的一个优点是它能够测量人类注释的一致性。除此之外,人类一致性研究本身也是一个有趣的目的,它使我们能够详细了解任务,包括我们提出的度量的细节以及人类一致性沿各个轴的细分。这使我们能够洞察任务带来的内在挑战,而不会因算法选择而影响我们的分析。此外,人体研究有助于地面机器性能(见§7),并允许我们校准对任务的理解。

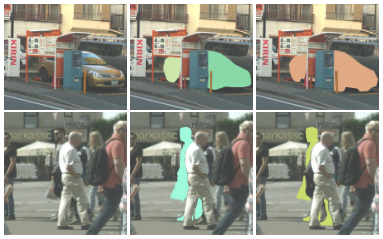

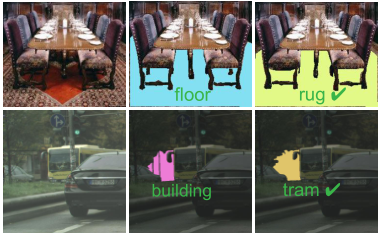

图3:分割缺陷。图像被缩放和裁剪。顶行(Vistas图像):两个注释器都将目标标识为汽车,但其中一个注释器将汽车拆分为两辆汽车。下一行(Cityscapes图像):分割确实是模糊的。

图4:缺陷分类。图像被缩放和裁剪。顶行(ADE20k图像):简单的错误分类。下一行(Cityscapes图片):场景非常困难,电车是该段的正确类别。许多错误很难解决。

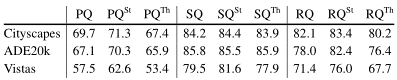

表1:stuff和things人的一致性。全景、分割和识别质量(PQ、SQ、RQ)在类别上的平均值(PQ= SQ×RQ对于每个类别)报告为百分比。也许令人惊讶的是,我们发现每个数据集上的人类一致性对于stuff和things都是相对相似的。

表2:小型(S)、中型(M)和大型(L)目标的人类一致性与尺度。尺度在确定全景分割的人类一致性方面起着重要作用。在大型对象上,所有数据集上的SQ和RQ都高于80,而对于小型对象,RQ急剧下降。小物体的SQ是相对合理的。

人类注释。为了实现人类一致性分析,数据集创建者慷慨地为我们提供了30幅Cityscapes双注释图像、64幅ADE20k图像和46幅Vistas图像。对于Cityscapes和Vistas,图像由不同的注释器独立注释。ADE20k由一名训练有素的注释员进行注释,该注释员以六个月的间隔标记同一组图像。为了测量人类注释器的全景质量(PQ),我们将每个图像的一个注释视为真值,另一个作为预测。请注意,PQ与真值和预测是对称的,因此顺序不重要。

人类的一致性。首先,表1显示了每个数据集上的人类一致性,以及PQ分解为分割质量(SQ)和识别质量(RQ)。正如预期的那样,人类在这项任务上并不完美,这与[6、54、35]中的注释质量研究一致。人体分割和分类错误的可视化分别如图3和图4所示。

我们注意到,表1为每个数据集建立了注释者一致性的度量,而不是人类一致性的上限。我们进一步强调,数据集之间的数字不可比较,不应用于评估数据集质量。类的数量、注释像素的百分比和场景复杂度在不同的数据集中有所不同,每一个都会显著影响注释难度。

Stuff对things。PS需要对stuff和things进行分割。在表1中,我们还显示了PQSt和PQTh,它们分别是stuff类和thing类上的PQ平均值。对于Cityscapes和ADE20k来说,对stuff和things人类的一致性是相近的,但从Vistas来看,差距要大一些。总的来说,这意味着stuff和things有相似的难度,尽管thing类有点难。我们参考本文的arXiv版本以进一步分析度量。

小物体对大物体。为了分析PQ如何随对象大小变化,我们分别考虑每个数据集中最小25%、中间50%和最大25%的目标,将数据集划分为小(S)、中(M)和大(L)目标。在表2中,我们看到,对于大型目标,所有数据集的人类一致性都非常好。对于小目标,RQ显著下降,这意味着人类注释者通常很难找到小目标。然而,如果发现一个小目标,它会被分割得相对好。

7. 机器性能基线

我们现在提供了用于全景分割的简单机器基线。我们对三个问题感兴趣:(1)最佳实例和语义分割系统的启发式组合如何在全景分割上执行?(2)PQ与AP和IoU等现有指标相比如何?(3)机器结果与我们之前介绍的人类结果相比如何?

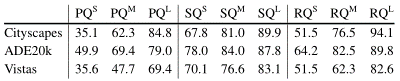

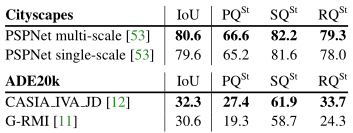

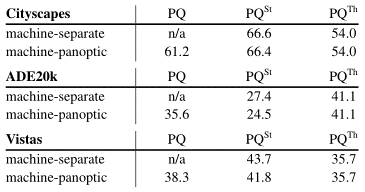

表3:实例分割的机器结果(忽略stuff类)。使用所提出的启发式算法获得非重叠预测。

A

P

N

O

AP^{NO}

APNO是非重叠预测的AP。正如预期的那样,消除重叠会损害AP,因为检测器从预测多个重叠假设中获益。AP较好的方法也有较好的

A

P

N

O

AP^{NO}

APNO 和同样改善的PQ。

表4:语义分割的机器结果(忽略thing类)。具有更好平均IoU的方法也显示出更好的PQ结果。注意,G-RMI具有相当低的PQ。我们发现这是因为它会使图像中不存在的类的许多小块产生幻觉。虽然这仅轻微影响计算像素误差的IoU,但严重降低了计算实例误差的PQ。

算法和数据。我们希望根据现有的成熟方法来理解全景分割。因此,我们通过将合理的启发式(稍后描述)应用于现有的顶级实例和语义分割系统的输出,创建了一个基本的PS系统。

我们获得了三个数据集的算法输出。对于Cityscapes,我们使用当前领先算法生成的验证集输出(分别用于语义和实例分割的PSPNet[53]和Mask R-CNN[14])。对于ADE20k,我们收到了2017年Places Challenge的1k测试图像子集上语义[12,11]和实例[31,10]分割轨迹的获胜者的输出。对于用于LSUN’17分割挑战的Vistas,组织者为我们提供了1k个测试图像以及实例和语义分割轨道的获奖作品的结果[29,52]。

使用这些数据,我们首先分别分析实例和语义分割任务的PQ,然后检查完整的全景分割任务。请注意,我们的“基线”非常强大,更简单的基线可能更适合在PS论文中进行公平比较。

实例分割。实例分割算法产生重叠片段。为了测量PQ,我们必须首先解决这些重叠。为此,我们开发了一个简单的非最大抑制(NMS)类程序。我们首先根据预测片段的置信度对其进行排序,并删除得分较低的实例。然后,我们从最自信的实例开始迭代排序的实例。对于每个实例,我们首先移除已分配给先前片段的像素,然后,如果足够部分的片段剩余,我们接受非重叠部分,否则我们丢弃整个片段。通过网格搜索选择所有阈值以优化PQ。Cityscapes和ADE20k的结果如表3所示(Vistas被省略,因为它只有一个2017年实例挑战的条目)。最重要的是,AP和PQ跟踪密切,我们预计探测器AP的改进也将改善其PQ。

语义分割。语义分割在设计上没有重叠分段,因此我们可以直接计算PQ。在表4中,我们将此任务的标准度量平均IoU与PQ进行了比较。对于Cityscapes,方法之间的PQ差距对应于IoU差距。对于ADE20k,差距要大得多。这是因为,虽然IoU对正确预测的像素进行计数,但PQ在实例级别进行操作。详见表4标题。

全景分割。为了生成PS的算法输出,我们从前面描述的类似NMS的过程中的非重叠实例片段开始。然后,我们将这些片段与语义分割结果相结合,通过解决有利于ting类的thing和stuff类之间的任何重叠(即,为具有thing和stuff标签的像素分配thing标签及其实例id)。这种启发式方法虽然不完善,但足以作为基线。

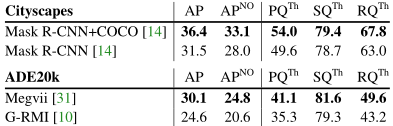

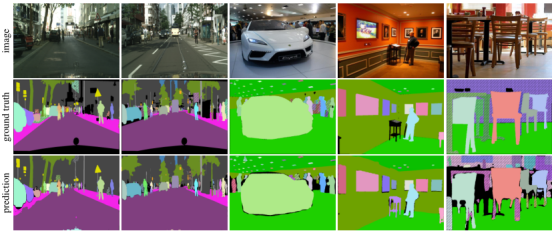

表5将根据组合(“全景”)结果计算的PQSt和PQTh与上述单独预测的性能进行了比较。对于这些结果,我们使用了来自各个竞赛的获胜条目,用于实例和语义任务。由于重叠的解决有利于things,因此对于全景预测,PQTh是恒定的,而PQSt稍低。全景输出的可视化如图5所示。

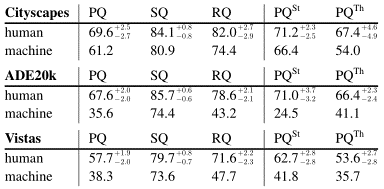

人与机器全景分割。为了比较人与机器的PQ,我们使用上述机器全景预测。对于人工结果,我们使用§6中描述的双注释图像,并使用自举法获得置信区间,因为这些图像集很小。这些比较是不完美的,因为它们使用不同的测试图像,并且在不同类别上进行平均(省略了双注释测试集中没有匹配的某些类别),但它们仍然可以给出一些有用的信号。

我们在表6中给出了比较结果。对于SQ,机器仅略微落后于人类。另一方面,机器RQ明显低于人类RQ,尤其是在ADE20k和Vistas上。这意味着识别,即分类,是当前方法的主要挑战。总的来说,人和机器性能之间存在着巨大的差距。我们希望这一差距将激励未来对所提出的全景分割任务的研究。

图5:Cityscapes(左二)和ADE20k(右三)的全景分割结果。预测基于最先进的实例和语义分割算法的合并输出(见表3和表4)。匹配片段(IoU>0.5)的颜色匹配(交叉阴影图案表示不匹配区域,黑色表示未标记区域)。以彩色和缩放方式查看效果最佳。

表5:全景预测与独立预测。“机器分割”行显示了独立计算的语义和实例分割方法的PQ(另见表3和表4)。对于“机器全景”,我们将从最先进的方法获得的不重叠的ting和stuff预测合并到图像的真实全景分割中。由于使用了合并启发式,

P

Q

T

h

PQ^{Th}

PQTh保持不变,而

P

Q

S

t

PQ^{St}

PQSt略有下降。

表6:人与机器性能。在所考虑的每个数据集上,人的一致性远远高于机器性能(近似比较,详见正文)。RQ尤其如此,而SQ更接近。这一差距在ADE20k上最大,在Cityscapes上最小。注意,由于只有一小部分人工注释可用,我们使用自举并显示人工结果的第5和第95百分位误差范围。

8. 全景分割的未来

我们的目标是通过邀请社区探索新的全景分割任务,推动新方向的研究。我们相信,拟议的任务可以带来预期和意想不到的创新。最后,我们讨论了其中一些可能性和我们的未来计划。

出于简单性的考虑,本文中的PS“算法”是基于顶级实例和语义分割系统的输出的启发式组合。这种方法是基本的第一步,但我们希望引入更多有趣的算法。具体而言,我们希望PS至少在两个领域推动创新:(1)深度集成的端到端模型,同时解决PS的双重属性。包括[28、2、3、18]在内的许多实例分割方法旨在产生非重叠的实例预测,并可作为此类系统的基础。(2) 由于PS不能有重叠的片段,某种形式的更高层次的“推理”可能是有益的,例如,基于将可学习NMS[7,16]扩展到PS。我们希望全景分割任务将激励这些领域的研究,从而在视觉方面取得令人兴奋的新突破。

最后,我们注意到,全景分割任务被COCO[25]和Mapillary Vistas[35]识别挑战作为一个挑战轨道,并且建议的任务已经开始在社区中获得吸引力(例如[23、47、48、27、22、21、17]解决PS)。

Acknowledgements: This work was partially funded by the European Research Council(ERC) under the European Unions Horizon 2020 research and innovation programme (gr. #647769).

References

[1] Edward H Adelson. On seeing stuff: the perception of materials by humans and machines. In Human Vision and Electronic Imaging, 2001. 1

[2] Anurag Arnab and Philip HS Torr. Pixelwise instance segmentation with a dynamically instantiated network. In CVPR, 2017. 2, 3, 8

[3] Min Bai and Raquel Urtasun. Deep watershed transform for instance segmentation. In CVPR, 2017. 3, 8

[4] Holger Caesar, Jasper Uijlings, and Vittorio Ferrari. COCO-Stuff: Thing and stuff classes in context. In CVPR, 2018. 2, 5

[5] Liang-Chieh Chen, George Papandreou, Iasonas Kokkinos,Kevin Murphy, and Alan L Yuille. DeepLab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs. PAMI, 2018. 1

[6] Marius Cordts, Mohamed Omran, Sebastian Ramos, Timo Rehfeld, Markus Enzweiler, Rodrigo Benenson, Uwe Franke, Stefan Roth, and Bernt Schiele. The cityscapes dataset for semantic urban scene understanding. In CVPR, 2016. 2, 3, 5, 6

[7] Chaitanya Desai, Deva Ramanan, and Charless C Fowlkes. Discriminative models for multi-class object layout. IJCV, 2011. 8

[8] P. Dollár, C. Wojek, B. Schiele, and P. Perona. Pedestrian detection: An evaluation of the state of the art. PAMI, 2012. 2

[9] Mark Everingham, SM Ali Eslami, Luc Van Gool, Christopher KI Williams, John Winn, and Andrew Zisserman. The PASCAL visual object classes challenge: A retrospective. IJCV, 2015. 2, 3

[10] Alireza Fathi, Nori Kanazawa, and Kevin Murphy. Places challenge 2017: instance segmentation, G-RMI team. 2017. 7

[11] Alireza Fathi, Kai Yang, and Kevin Murphy. Places challenge 2017: scene parsing, G-RMI team. 2017. 7

[12] Jun Fu, Jing Liu, Longteng Guo, Haijie Tian, Fei Liu, Hanqing Lu, Yong Li, Yongjun Bao, and Weipeng Yan. Places challenge 2017: scene parsing, CASIA IVA JD team. 2017. 7

[13] Bharath Hariharan, Pablo Arbeláez, Ross Girshick, and Jitendra Malik. Simultaneous detection and segmentation. In ECCV, 2014. 4, 5

[14] Kaiming He, Georgia Gkioxari, Piotr Dollár, and Ross Girshick. Mask R-CNN. In ICCV, 2017. 1, 2, 7

[15] J. Hosang, R. Benenson, P. Dollár, and B. Schiele. What makes for effective detection proposals? PAMI, 2015. 1

[16] J Hosang, R Benenson, and B Schiele. Learning non-maximum suppression. PAMI, 2017. 8

[17] Alexander Kirillov, Ross Girshick, Kaiming He, and Piotr Dollár. Panoptic feature pyramid networks. In CVPR, 2019. 8

[18] Alexander Kirillov, Evgeny Levinkov, Bjoern Andres, Bogdan Savchynskyy, and Carsten Rother. InstanceCut: from edges to instances with multicut. In CVPR, 2017. 2, 3, 8

[19] Iasonas Kokkinos. UberNet: Training a universal convolutional neural network for low-, mid-, and high-level vision using diverse datasets and limited memory. In CVPR, 2017. 3

[20] Alex Krizhevsky, Ilya Sutskever, and Geoff Hinton. ImageNet classification with deep convolutional neural networks. In NIPS, 2012. 2

[21] Jie Li, Allan Raventos, Arjun Bhargava, Takaaki Tagawa, and Adrien Gaidon. Learning to fuse things and stuff. arXiv:1812.01192, 2018. 8

[22] Qizhu Li, Anurag Arnab, and Philip HS Torr. Weakly-and semi-supervised panoptic segmentation. In ECCV, 2018. 8

[23] Yanwei Li, Xinze Chen, Zheng Zhu, Lingxi Xie, Guan Huang, Dalong Du, and Xingang Wang. Attention-guided unified network for panoptic segmentation. arXiv:1812.03904, 2018. 8

[24] Yi Li, Haozhi Qi, Jifeng Dai, Xiangyang Ji, and Yichen Wei. Fully convolutional instance-aware semantic segmentation. In CVPR, 2017. 2

[25] Tsung-Yi Lin, Michael Maire, Serge Belongie, James Hays, Pietro Perona, Deva Ramanan, Piotr Dollár, and C Lawrence Zitnick. Microsoft COCO: Common objects in context. In ECCV, 2014. 2, 5, 8

[26] Ce Liu, Jenny Yuen, and Antonio Torralba. SIFT flow: Dense correspondence across scenes and its applications. PAMI, 2011. 2, 3

[27] Huanyu Liu, Chao Peng, Changqian Yu, Jingbo Wang, Xu Liu, Gang Yu, and Wei Jiang. An end-to-end network for panoptic segmentation. arXiv:1903.05027, 2019. 8

[28] Shu Liu, Jiaya Jia, Sanja Fidler, and Raquel Urtasun. SGN: Sequential grouping networks for instance segmentation. In CVPR, 2017. 2, 3, 8

[29] Shi Liu, Lu Qi, Haifang Qin, Jianping Shi, and Jiaya Jia. LSUN’17: insatnce segmentation task, UCenter winner team. 2017. 7

[30] Jonathan Long, Evan Shelhamer, and Trevor Darrell. Fully convolutional networks for semantic segmentation. In CVPR, 2015. 1, 3, 5

[31] Ruixuan Luo, Borui Jiang, Tete Xiao, Chao Peng, Yuning Jiang, Zeming Li, Xiangyu Zhang, Gang Yu, Yadong Mu, and Jian Sun. Places challenge 2017: instance segmentation, Megvii (Face++) team. 2017. 7

[32] Jitendra Malik, Pablo Arbeláez, Jo˜ ao Carreira, Katerina Fragkiadaki, Ross Girshick, Georgia Gkioxari, Saurabh Gupta, Bharath Hariharan, Abhishek Kar, and Shubham Tulsiani. The three R’s of computer vision: Recognition, reconstruction and reorganization. PRL, 2016. 3

[33] David R Martin, Charless C Fowlkes, and Jitendra Malik. Learning to detect natural image boundaries using localbrightness, color, and texture cues. PAMI, 2004. 5

[34] Ishan Misra, Abhinav Shrivastava, Abhinav Gupta, and Martial Hebert. Cross-stitch networks for multi-task learning. In CVPR, 2016. 3

[35] Gerhard Neuhold, Tobias Ollmann, Samuel Rota Bulò, and PeterKontschieder. The mapillary vistas dataset for semantic understanding of street scenes. In CVPR, 2017. 2, 3, 5, 6, 8

[36] Pedro O Pinheiro, Ronan Collobert, and Piotr Dollár. Learning to segment object candidates. In NIPS, 2015. 2

[37] Shaoqing Ren, Kaiming He, Ross Girshick, and Jian Sun. Faster R-CNN: Towards real-time object detection with region proposal networks. In NIPS, 2015. 1

[38] Olga Russakovsky, Jia Deng, Hao Su, Jonathan Krause, Sanjeev Satheesh, Sean Ma, Zhiheng Huang, Andrej Karpathy, Aditya Khosla, Michael Bernstein, Alexander C. Berg, and

Li Fei-Fei. ImageNet Large Scale Visual Recognition Challenge. IJCV, 2015. 2

[39] Jamie Shotton, John Winn, Carsten Rother, and Antonio Criminisi. Textonboost: Joint appearance, shape and context modeling for multi-class object recog. and segm. In ECCV,

2006. 2

[40] Min Sun, B. Kim, Pushmeet Kohli, and Silvio Savarese. Relating things and stuff via object property interactions. PAMI, 2014. 3, 4

[41] Joseph Tighe and Svetlana Lazebnik. Finding things: Image parsing with regions and per-exemplar detectors. In CVPR, 2013. 3, 4

[42] Joseph Tighe, Marc Niethammer, and Svetlana Lazebnik. Scene parsing with object instances and occlusion ordering. In CVPR, 2014. 2, 3, 4

[43] Zhuowen Tu, Xiangrong Chen, Alan L Yuille, and Song-Chun Zhu. Image parsing: Unifying segmentation, detection, and recognition. IJCV, 2005. 2, 3

[44] R. Vaillant, C. Monrocq, and Y. LeCun. Original approach for the localisation of objects in images. IEE Proc. on Vision, Image, and Signal Processing, 1994. 2

[45] CJ Van Rijsbergen. Information retrieval. London: Butterworths, 1979. 5

[46] Paul Viola and Michael Jones. Rapid object detection using a boosted cascade of simple features. In CVPR, 2001. 2

[47] Yuwen Xiong, Renjie Liao, Hengshuang Zhao, Rui Hu, Min Bai, Ersin Yumer, and Raquel Urtasun. UPSNet: A unified panoptic segmentation network. arXiv:1901.03784, 2019. 8

[48] Tien-Ju Yang, Maxwell D Collins, Yukun Zhu, Jyh-Jing Hwang, Ting Liu, Xiao Zhang, Vivienne Sze, George Papandreou, and Liang-Chieh Chen. DeeperLab: Single-shot image parser. arXiv:1902.05093, 2019. 8

[49] Yi Yang, Sam Hallman, Deva Ramanan, and Charless C Fowlkes. Layered object models for image segmentation. PAMI, 2012. 4

[50] Jian Yao, Sanja Fidler, and Raquel Urtasun. Describing the scene as a whole: Joint object detection, scene classification and semantic segmentation. In CVPR, 2012. 2, 3, 4

[51] Fisher Yu and Vladlen Koltun. Multi-scale context aggregation by dilated convolutions. In ICLR, 2016. 1

[52] Yi Zhang, Hengshuang Zhao, and Jianping Shi. LSUN’17: semantic segmentation task, PSPNet winner team. 2017. 7

[53] Hengshuang Zhao, Jianping Shi, Xiaojuan Qi, Xiaogang Wang, and Jiaya Jia. Pyramid scene parsing network. In CVPR, 2017. 7

[54] Bolei Zhou, Hang Zhao, Xavier Puig, Sanja Fidler, Adela Barriuso, and Antonio Torralba. Scene parsing through ADE20K dataset. In CVPR, 2017. 2, 3, 5, 6

[55] Yan Zhu, Yuandong Tian, Dimitris Mexatas, and Piotr Dollár. Semantic amodal segmentation. In CVPR, 2017. 3