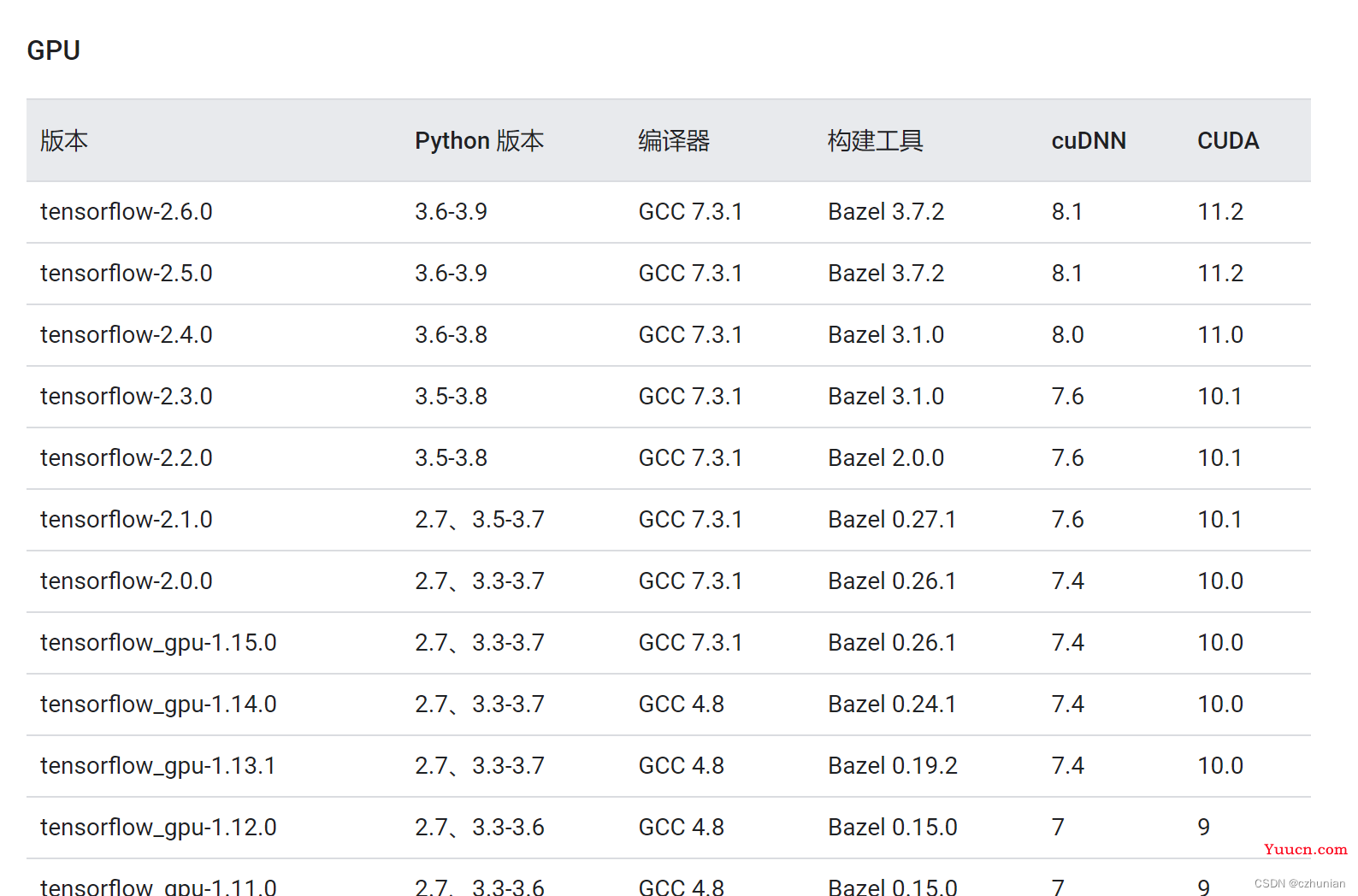

一、cuda安装,cuda 和 TensorFlow 版本对应,链接https://www.tensorflow.org/install/source#tested_source_configurations

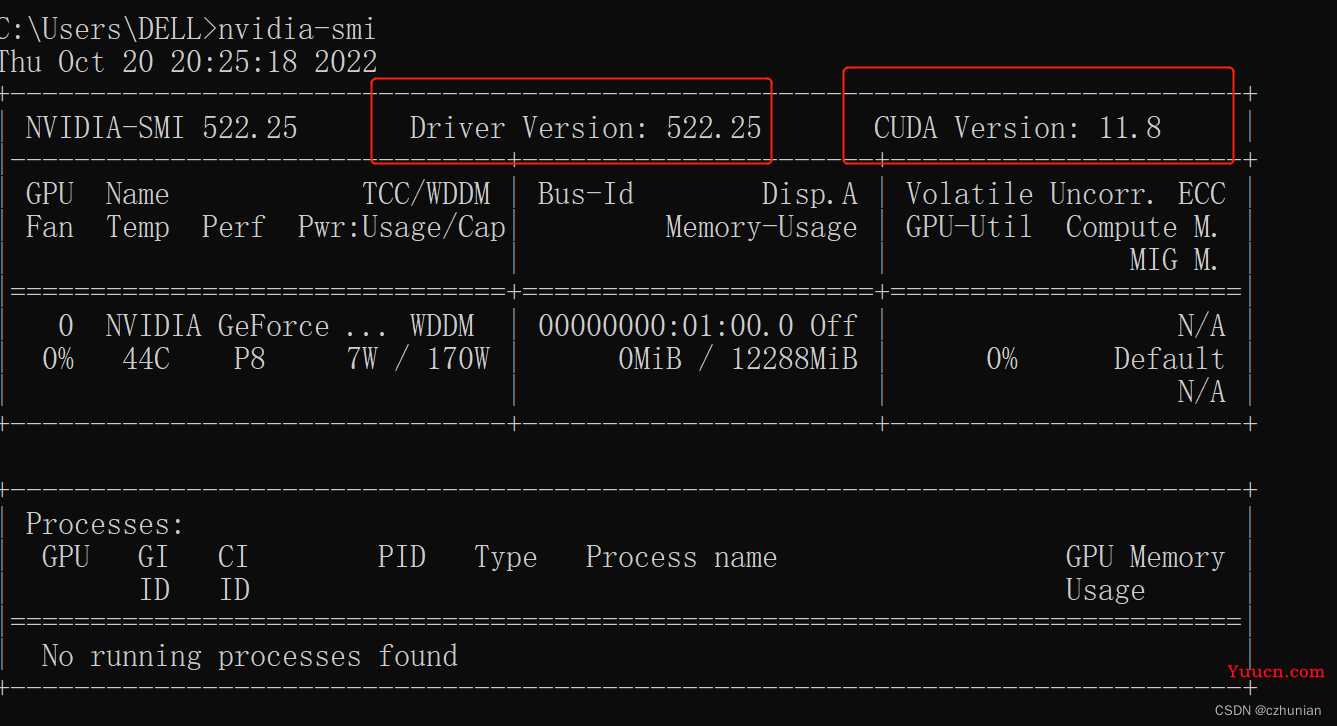

1.查看自己安装的驱动版本, nvidia-smi

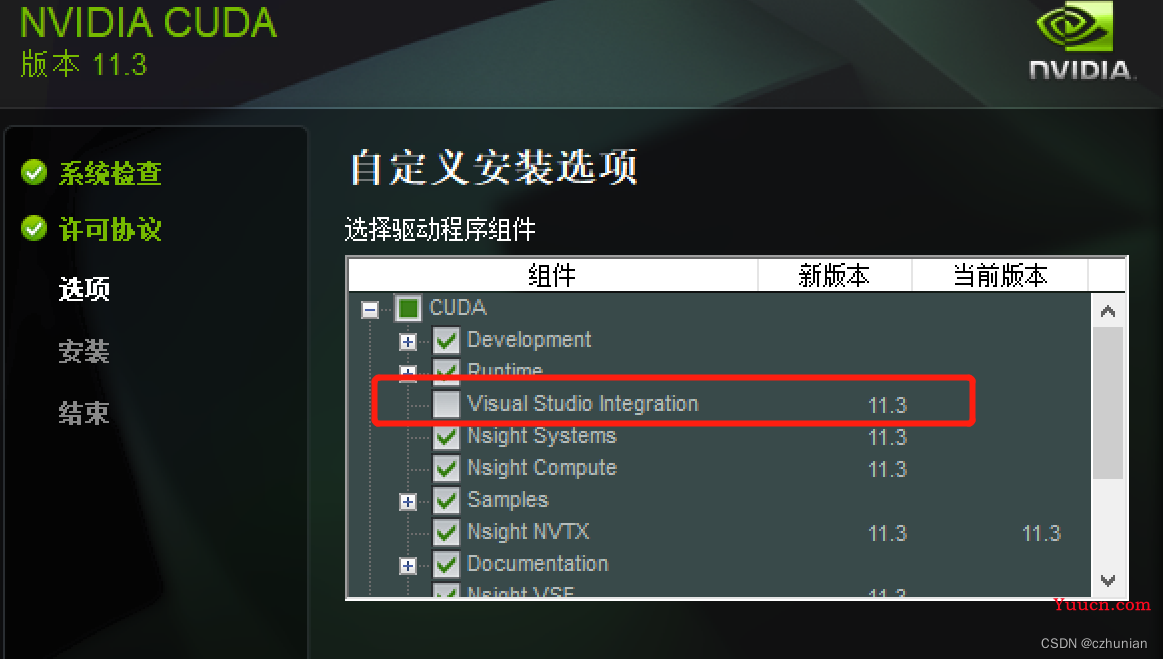

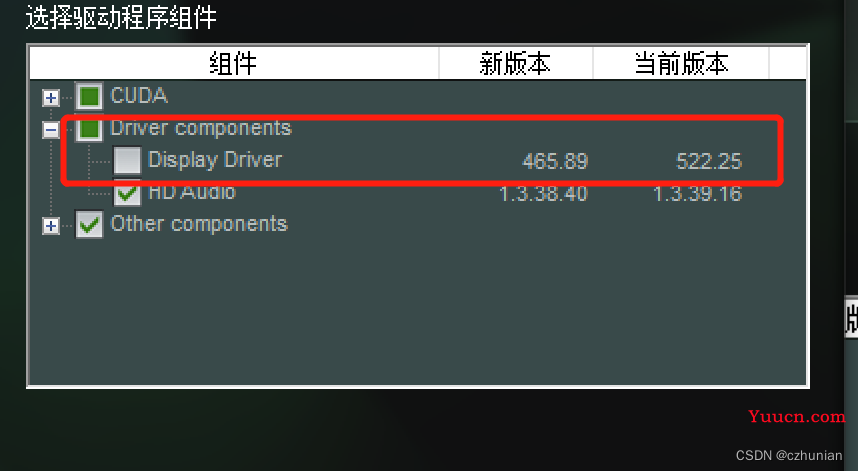

2.安装所需要的cuda,下载链接CUDA Toolkit Archive | NVIDIA Developer

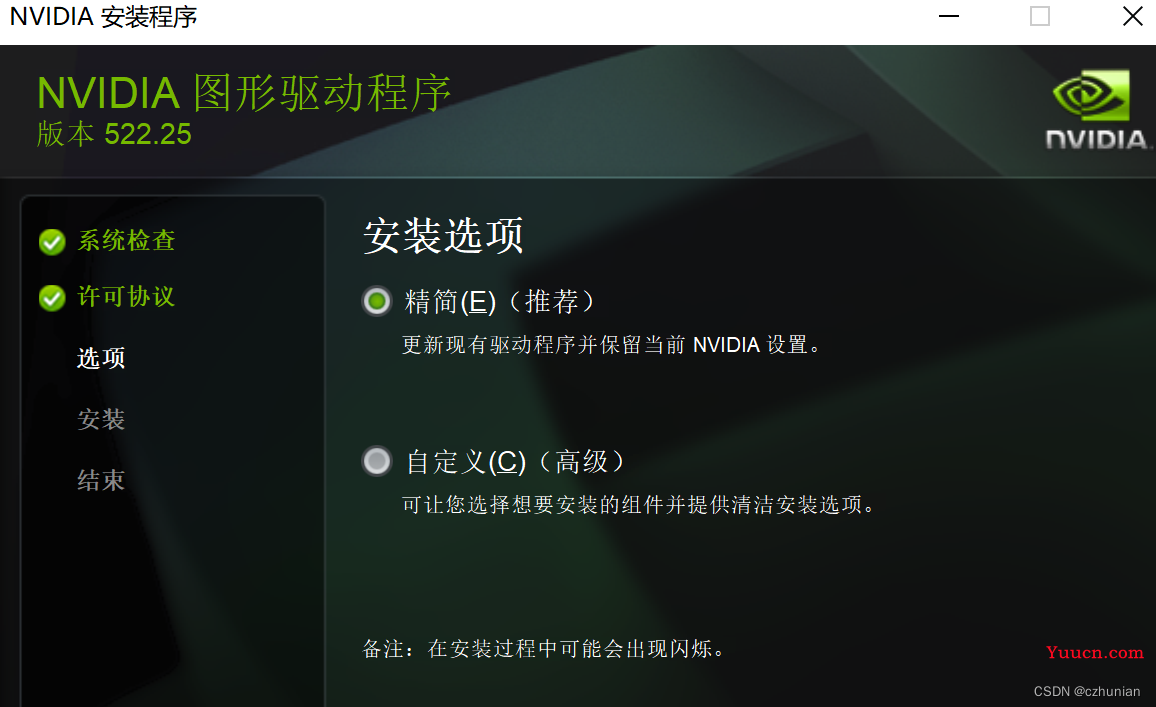

找到所需版本,下载对应环境 ,自定义安装, 查看新驱动版本,若不高于当前版本,则不安装 。

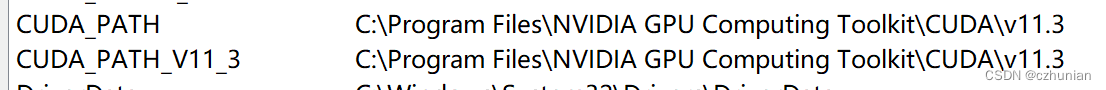

安装成功之后,配置环境变量,安装路径要记得。

(安装不成功的话,卸载驱动,再次安装,即可成功。卸载可以使用软件 提取码:1233)

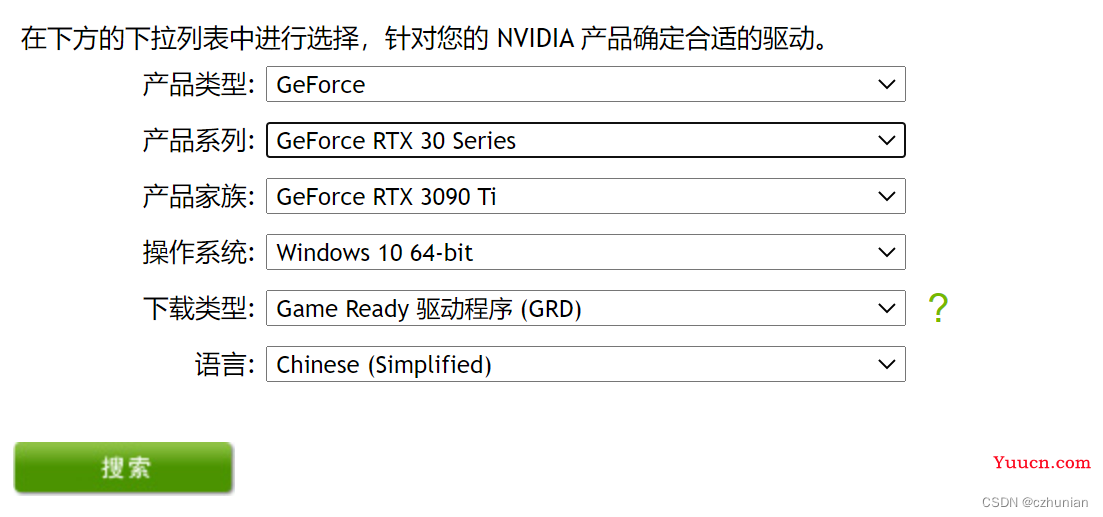

(如果cudatookit安装成功之后,发现显卡找不到,那就官网

安装一个驱动即可)

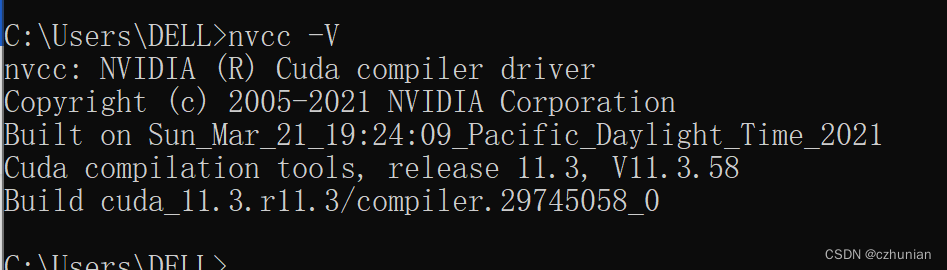

查看安装的cuda 版本

这边的版本跟nvidia-smi对应的cuda版本不一样,可以看下述第四点解释

二、cuDNN神经网络加速库安装

cuDNN不是应用程序,而是几个文件包,下载后把它复制到CUDA 的目录下即可。

cuDNN下载页:cuDNN下载页(记得版本对应,看上面)

cuDNN其实就是CUDA的一个补丁而已,专为深度学习运算进行优化的

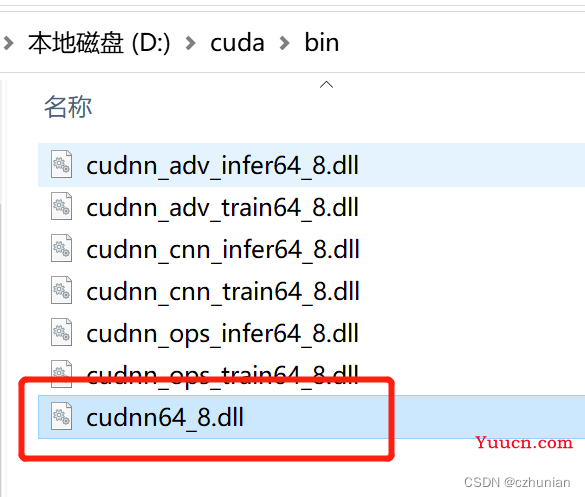

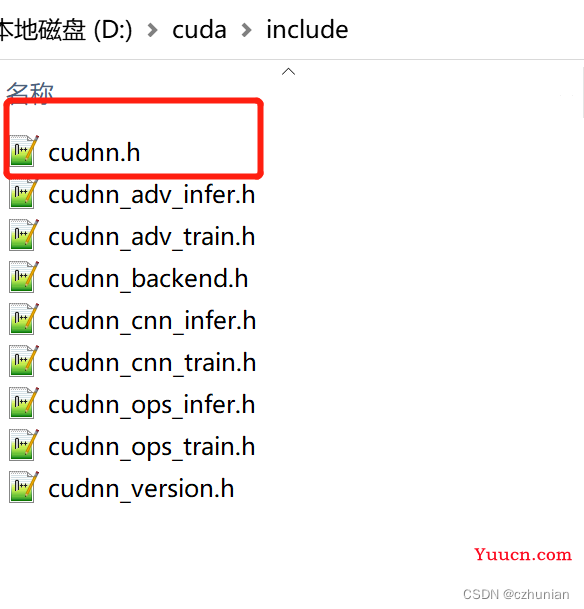

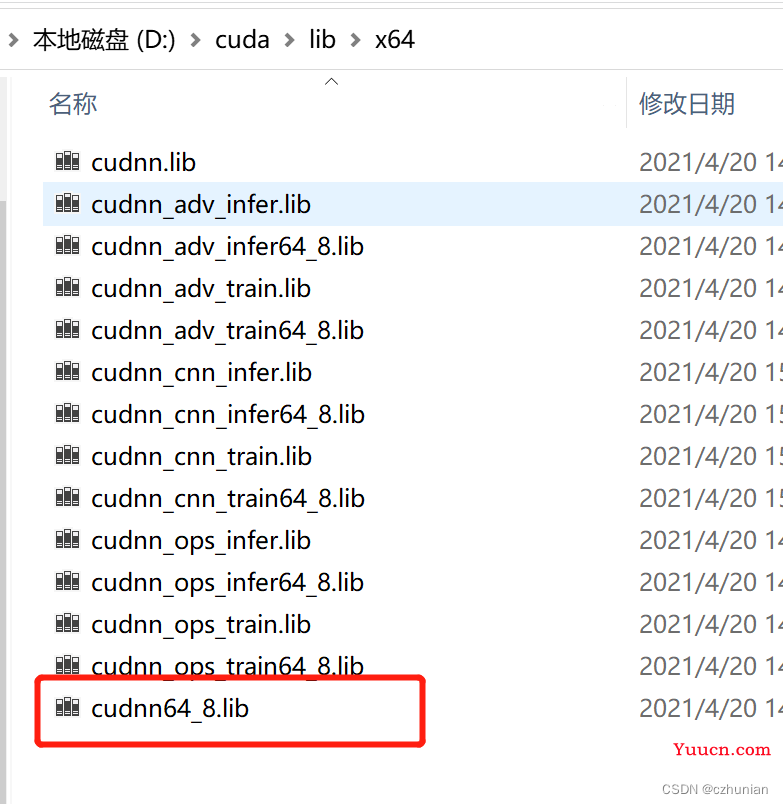

将include,lib,bin 下面这些文件拷贝到 v11.3目录下的对应目录。

或者说 直接将这三个目录 复制到 v11.3目录下(不覆盖文件复制)

三、安装TensorFlow2.5-gpu版本

1.安装指定版本的TensorFlow2.5.这边是直接下载wheel文件,然后创建一个虚拟环境(conda创建)教程 conda 安装 Pytorch(GPU)_czhunian的博客-CSDN博客_conda安装pytorch gpu

2.下载wheel链接https://github.com/fo40225/tensorflow-windows-wheel

选择对应版本,下载该版本下得全部文件即可。

3.在虚拟环境中,conda activate tf2 ,进入虚拟环境,之后切换到wheel文件路径,pip install命令安装

4. 测试,输出True代表安装成功

import tensorflow as tf

tf.test.is_gpu_available()四.cuda 和 NVIDIA驱动 版本关系,链接

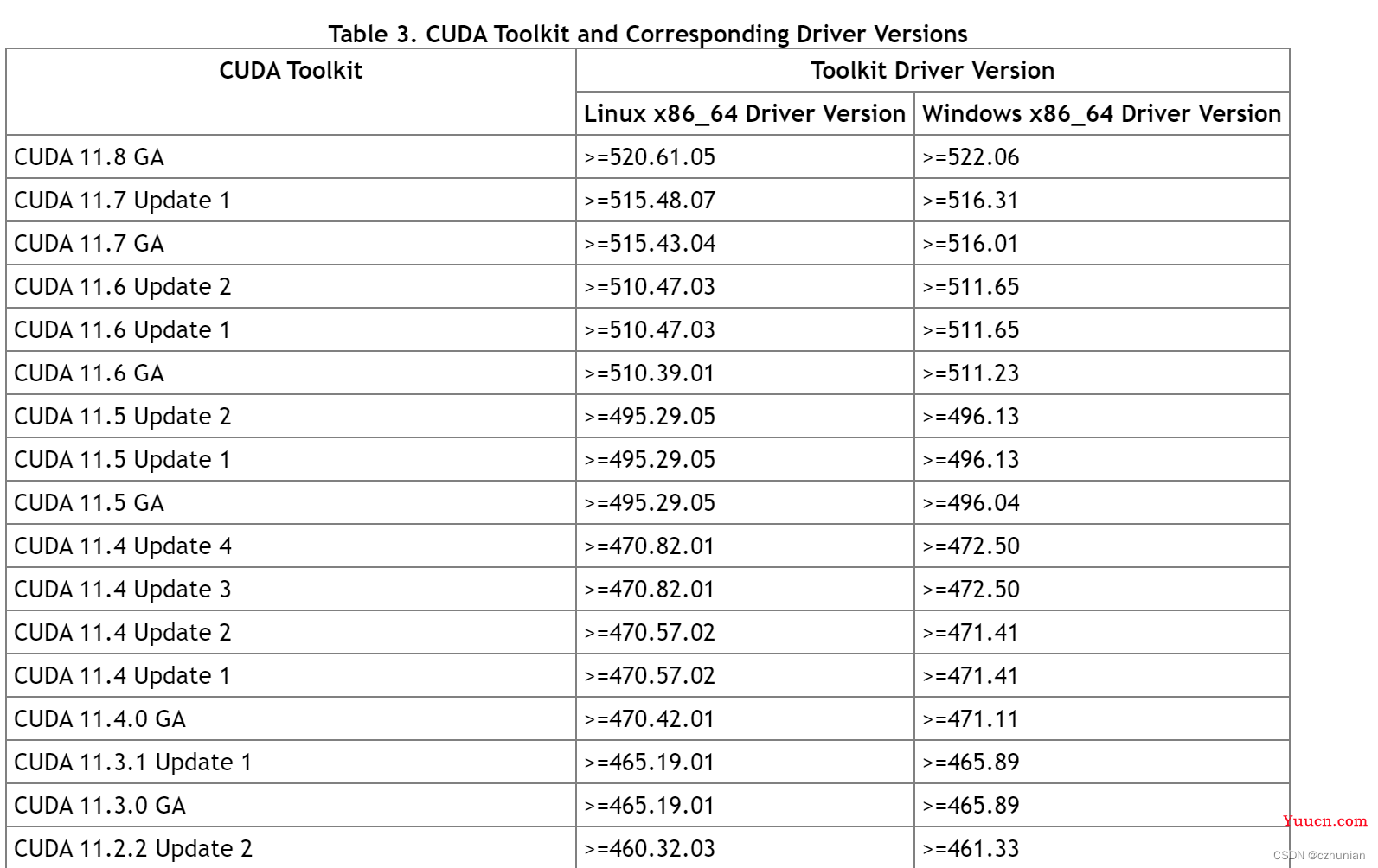

主要是看表三,cuda版本 和 驱动对应的关系。

查看 CUDA driver version(驱动版本):NVIDIA GPU的驱动程序版本(nvidia-smi)

查看 CUDA runtime version(运行时版本):自己安装的cudatoolkit包(nvcc -V)

- 用于支持driver API的必要文件(如

libcuda.so)是由GPU driver installer安装的。nvidia-smi就属于这一类API。 - 用于支持runtime API的必要文件(如

libcudart.so以及nvcc)是由CUDA Toolkit installer安装的。(CUDA Toolkit Installer有时可能会集成了GPU driver Installer)。nvcc是与CUDA Toolkit一起安装的CUDA compiler-driver tool,它只知道它自身构建时的CUDA runtime版本。它不知道安装了什么版本的GPU driver,甚至不知道是否安装了GPU driver。

综上,如果driver API和runtime API的CUDA版本不一致可能是因为你使用的是单独的GPU driver installer,而不是CUDA Toolkit installer里的GPU driver installer。

综上就是,驱动版本和运行时版本是不冲突(这边应该是运行时不能大于驱动版本即可),CUDA Toolkit(runtime)本质上只是一个工具包而已,甚至可以安装多个cudatoolkit版本,通过修改环境变量进行选择使用哪个版本的cuda。

五、总结

显卡驱动版本>=对应的cudatoolkit版本<=对应的tensorflow版本;因此cuda就是一个桥梁。

1、确定要安装的tensorflow版本。

2、根据tensorflow版本,确定cudatoolkit的版本 ,并确定cudann的版本。

3、根据cuda版本,确定显卡驱动的版本,不够就升级,够了就不管。