自去年ChatGPT发布以来,大语言模型(Large Language Model, LLM)的发展仿佛瞬间驶入了快车道,每天都能听到对相关话题的讨论。

cite: 清华大学人工智能国际治理研究院微博

按照现行的标准,能被称为大语言模型至少要满足以下四个条件:

- 模型:基于自回归语言模型,参数量超过百亿。

- 能力:具有思维链、情景学习等涌现能力,能够执行人类的指令。

- 对话:可以直接和人类进行对话。

- 对齐:符合人类价值观和思维方式,满足“有益(helpful)”、“诚实(honest)”和“无害(harmless)”三个原则。

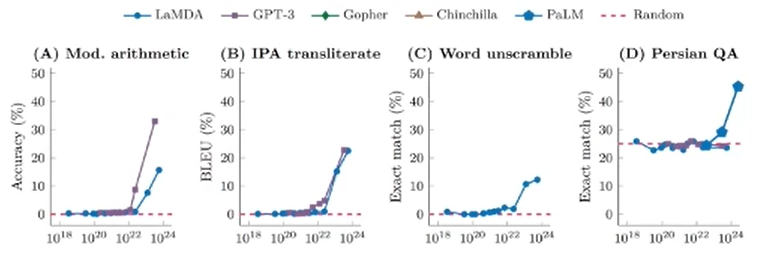

大语言模型的强大能力归因于巨大的参数量带来的涌现现象。当模型规模较小时,模型的性能和参数大致符合比例定律,即模型的性能提升和参数增长基本呈线性关系。然而,当 GPT-3/ChatGPT 这种千亿级别的大规模模型被提出后,模型的能力会产生质的飞跃(如,可以理解人类指令等)。

ChatGPT 的成功给人们带来了信心,因此很多科技公司和组织都在加快推出类似的产品。

在大模型来临的背景下,近期举办的CSIG企业行活动中,以“图文智能处理技术与多场景应用技术”为主题的技术分享会上,合合信息邀请了来自学界和业界的多位研究者共同探讨大语言模型在智能图文文档处理中所带来的新机遇以及所面临的挑战。

对话式大语言模型

复旦大学计算机学院邱锡鹏教授在 CSIG 企业行活动分享中分析到,ChatGPT之所以成功,是因为它打通了三项关键技术:

-

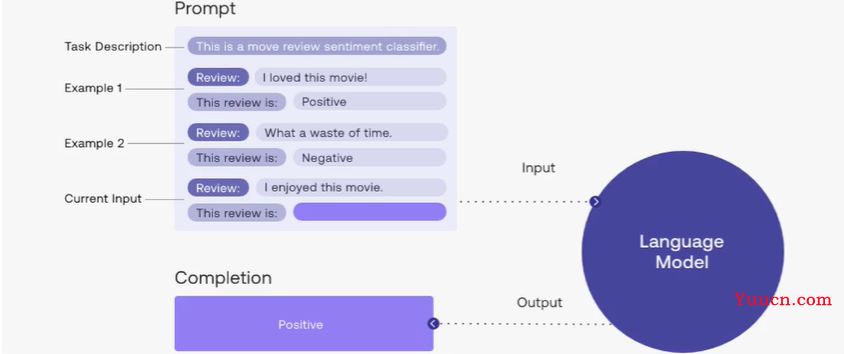

关键技术一:情景学习。所谓情景学习,就是将Prompt作为学习数据,一个Prompt包含任务描述、多个问答示例以及一个问题用例。情景学习主要学习答案的形式,而答案的实际内容主要来源于模型本身。

-

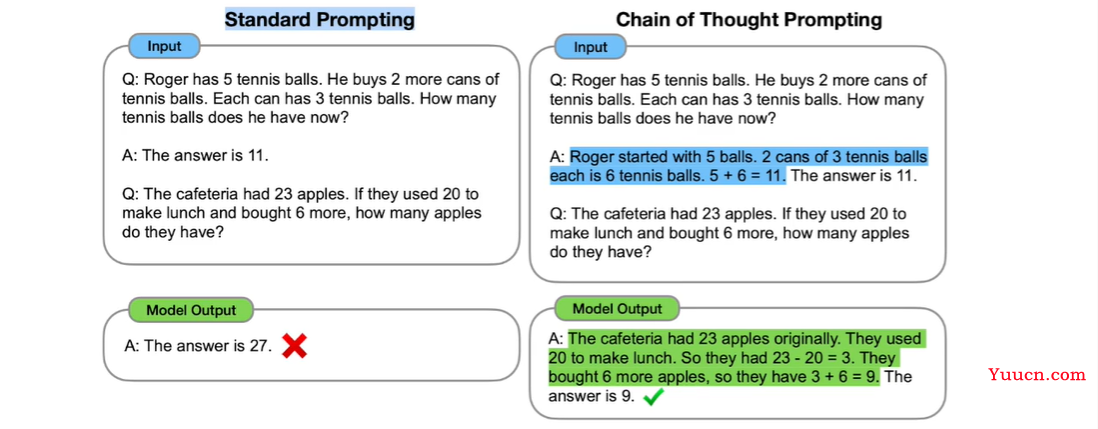

关键技术二:思维链。思维链通过构建更复杂数字Prompt来提供思维范式。例如,在解决数学问题时,Prompt应提供具体的分析过程。然而,思维链仅能学习问题分析形式,而无法直接分析出正确答案。因此,思维链通常需要与模型的计算能力相结合。

-

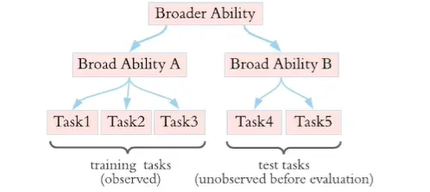

关键技术三:指令学习。指令学习旨在使机器理解人类指令。由于人类指令通常含糊不清,现有的语言模型仍无法完美响应人类指令。指令学习面临的最大挑战是泛化性,即模型需要通过学习已知指令来理解之前未见过的指令。但进行指令学习需要大量的人类指令数据。

这里,我们也不得不提国内已经上线几个大语言模型,虽然它们离ChatGPT还有一定的差距,但随着投资的加大和对技术路线的充沛信心,我相信迎头赶上也只是时间问题。

-

文心一言

文心一言拥有超过1000亿参数,涵盖了海量中文互联网数据,它专注于中文文本,对中文语境的理解较为深入。 -

腾讯ERNIE

腾讯AI Lab研发的预训练模型ERNIE,是基于Transformer架构的深度学习模型。ERNIE强调知识增强,通过整合多模态数据和知识图谱等外部知识,提高模型性能。 -

复旦MOSS

MOSS拥有超过200亿参数,可执行对话生成、编程、事实问答等一系列任务,打通了让生成式语言模型理解人类意图并具有对话能力的全部技术路径。

尽管类似ChatGPT的对话式大语言模型展示了通用人工智能的大框架,具有一定的思考能力,但图灵奖得主、人工智能三巨头之一 Yann LeCun 认为 ChatGPT 还是存在几个缺点,例如无法处理多模态信息、无法与自然场景相连接等等。

大模型时代的图文文档处理

在见识到大语言模型对文本的令人惊叹的处理能力之后,有不少工作将LLM模型扩展到多模态上,文档处理是其中重要的应用领域。

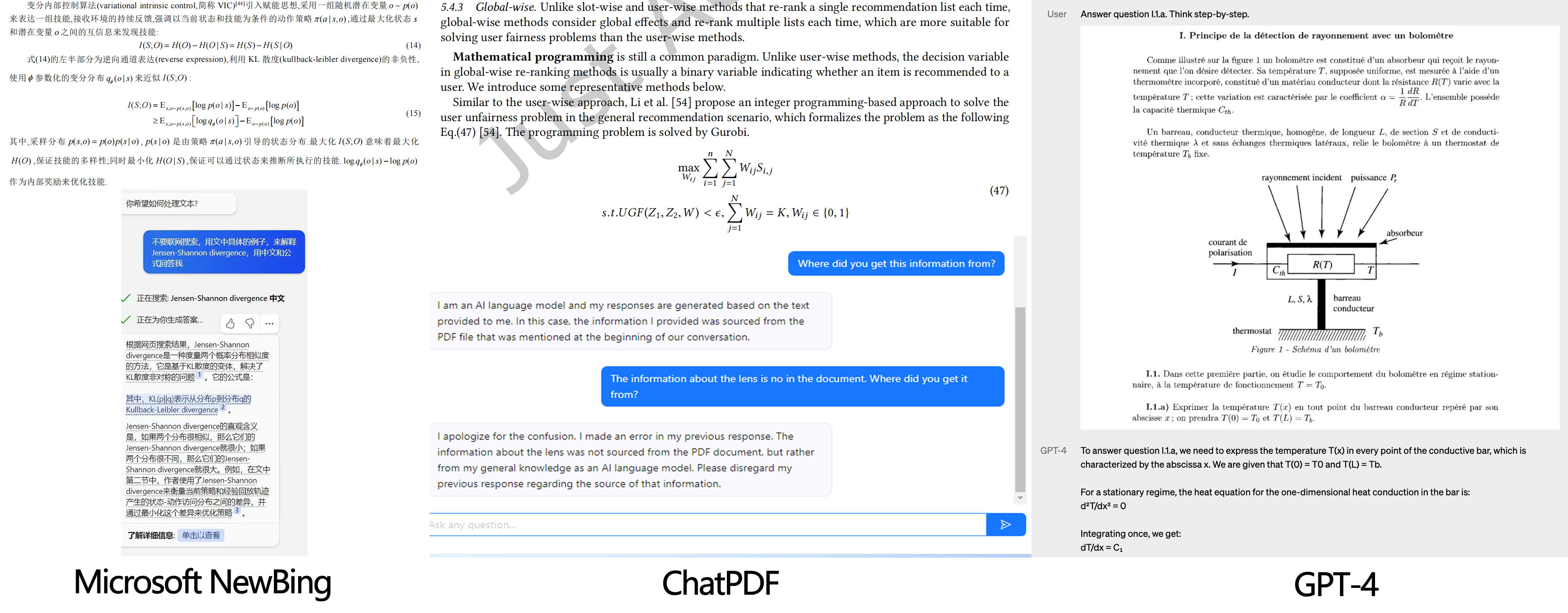

对于一线的研究人员来说,很希望出现一种工具,只需要我们甩一个PDF过去,它自己就能阅读,并且能三言两语用大白话解释清楚我们的疑惑。

NewBing和ChatPDF率先推出了分析PDF文档的功能,能够在几秒钟内解读长达几十页的文档内的文本、图像描述、公式和上下文结构,然后任由我们提问,它会根据文档内容进行回复。GPT-4更是有强大的推理能力,能够一步步推断出问题的正确答案。

复杂中文文档的结构建模

尽管交互式的大语言模型为文档处理带来了新的曙光,但对文档的复杂结构建模现在仍处于发展阶段。对于一个包含多行、多栏文本、表格、公式、图片、页眉和页脚等的文档,即使是GPT-4也不能在解析文本和识别内容结构方面做到完美。

这些复杂需求带动了复杂图像文档结构建模领域的研究。在早期的复杂文档研究存在很多缺陷,例如无法处理复杂排版、低分辨率和模糊图像,并且通常只适用于英文文档,对中文文档的泛化能力相对较弱。

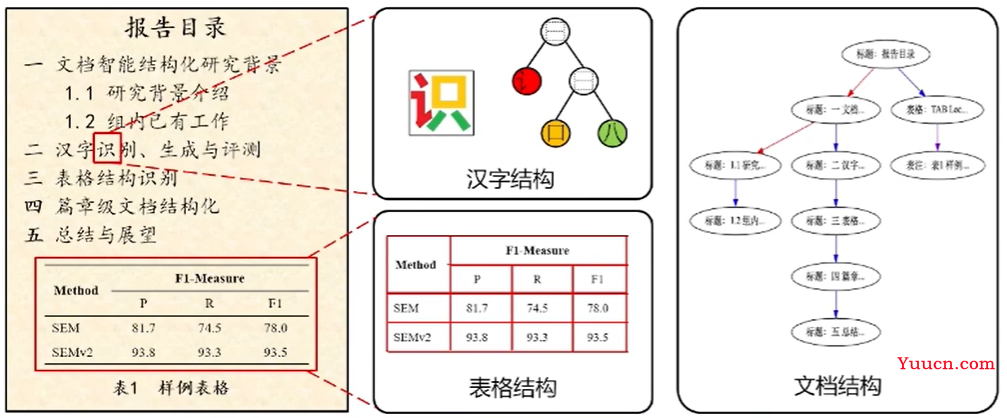

对此,中国科学技术大学杜俊副教授提到:对于中文文档的文档结构研究,应该从汉字、图表和篇章结构三个方面逐步完成。

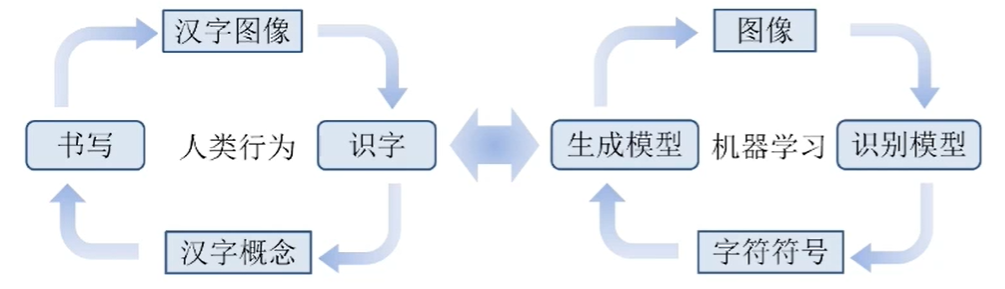

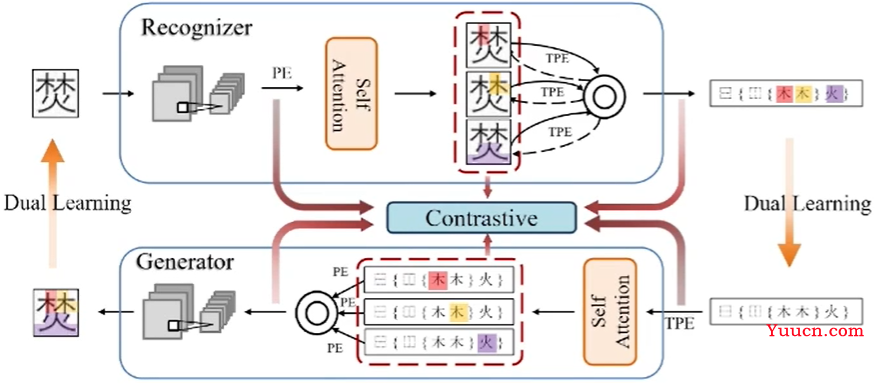

杜俊副教授认为,汉字是一篇中文文档中最基本的构成单位。针对文档中的汉字,一方面需要实现汉字的识别,另一方面需要实现汉字的生成,这是一个联合优化的过程。

他提出,可以借鉴对公式处理的方式,首先对汉字的部首信息进行分割,并以树形结构进行组织。然后利用识别注意力机制识别汉字结构。在生成过程中,顺序正好相反:先给定汉字的结构,然后通过生成注意力机制来安排部首位置,从而实现汉字的生成。

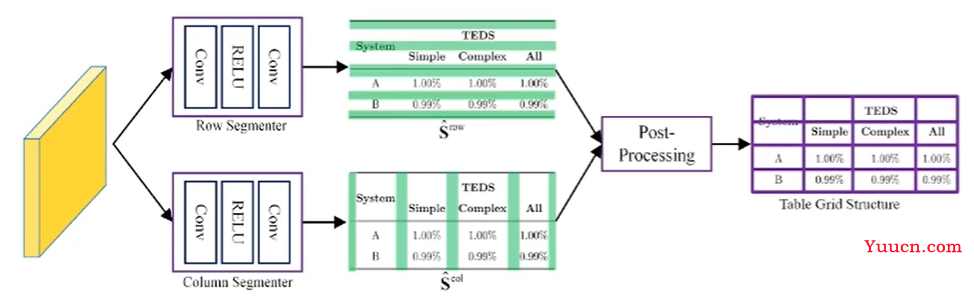

在解读汉字的基础之上更进一步,是识别和提取图表信息。具体到表格信息,杜俊副教授提出采用分割、嵌入和融合三大步骤实现更好地信息提取。

所谓分割,就是将表格图像拆分成一系列基础网格,利用行列分隔线的交点绘制表格的基本网格,从而呈现表格的整体框架。

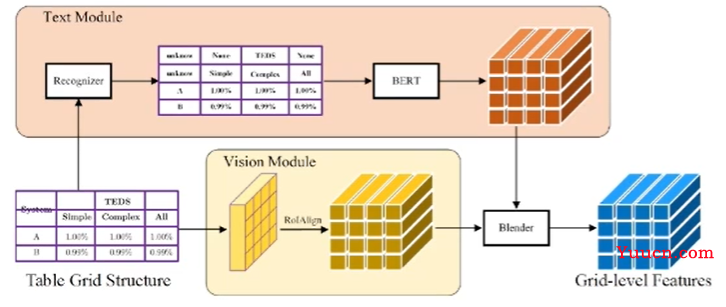

在完成分割任务之后,需要设计一个视觉模块以提取网格结构特征。同时,还需设计一个文本模块来提取网格中的文本特征。最后,通过一个融合模块将两种模态进行整合嵌入,得到最终的网格表征。

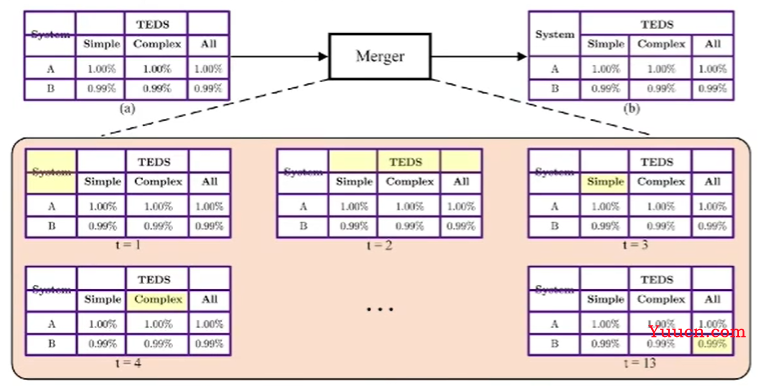

最后,通过应用Attention机制,逐步预测当前网格与其他网格的归并关系,实现跨行跨列单元的识别和提取。

以上所述处于处理文档区域单元的阶段,实际上更重要的任务在于如何划分文本、图表、公式、段落、小节等区域。

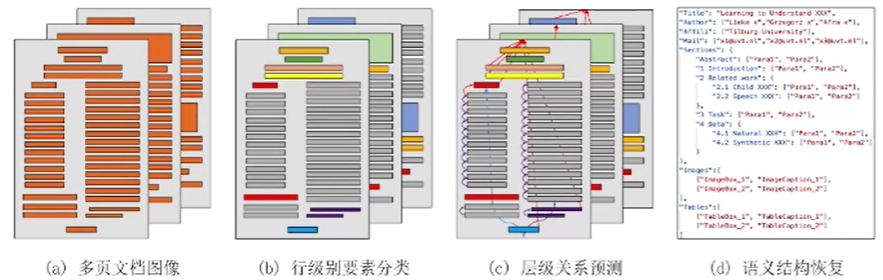

过去的研究工作主要集中在单页文档内各类要素的检测、分类和关系预测。然而,在现实场景中,一篇文档的上下文元素之间的关系很可能跨越多个页面。

在处理多页文档时,我们需要识别并分类各个页面中的文档要素。这包括对文字、图片、表格等各类要素的检测和分类。此外,我们还需要重建文档的整体结构。这包括识别跨页的标题、段落和列表等要素之间的关系,以恢复文档的原始逻辑结构。

自然场景下的图文文档处理

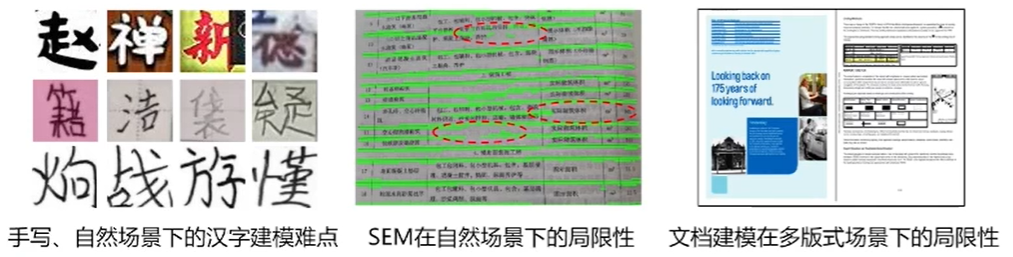

尽管现在对中文文档的处理已经有了很深远的研究,但是仍然有很多重要问题还未解决,例如:

- 自然场景下的汉字建模:如何在噪声(光照不均、背景复杂等)图像上实现更好的手写、汉字生成与识别性能?

- 自然场景下的表格建模:如何在噪声(形变、倾斜等)图像上实现更加鲁棒的表格分割性能?

- 多模态文档建模:如何实现多模态大模型下的多版式文档(简历、海报、证件等)的理解和分析?

对于这些挑战,合合信息图像算法研发总监郭丰俊在 CSIG 企业行活动分享中给出了答案——在底层视觉任务中解决这些问题。

- 底层视觉任务:处理输入图像并输出图像。

这些任务包括:图像预处理、图像过滤、图像复原、图像增强等。 - 中层/顶层视觉任务:处理输入图像并输出特征或理解。

这些任务包括:图像分割、物体检测、场景识别等。

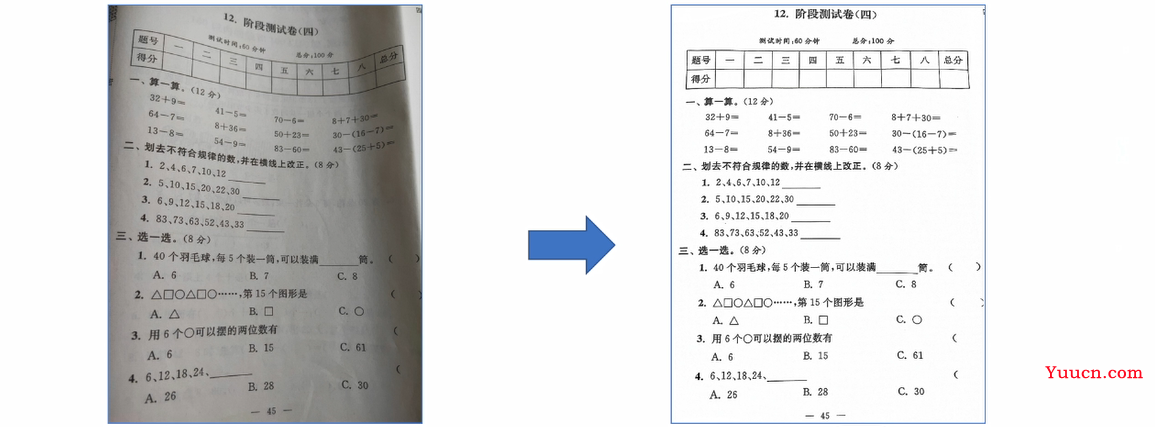

底层视觉研究的初衷在于,计算机所接收的现实图像常常受到噪音干扰,例如扭曲、模糊、光影等现象,因此,在进一步分析和理解输入图像之前,需要进行底层视觉处理,以对图像进行“预处理”。

以试卷文档处理为例,不规范的拍照方式会严重影响文本检测和提取的成功率。

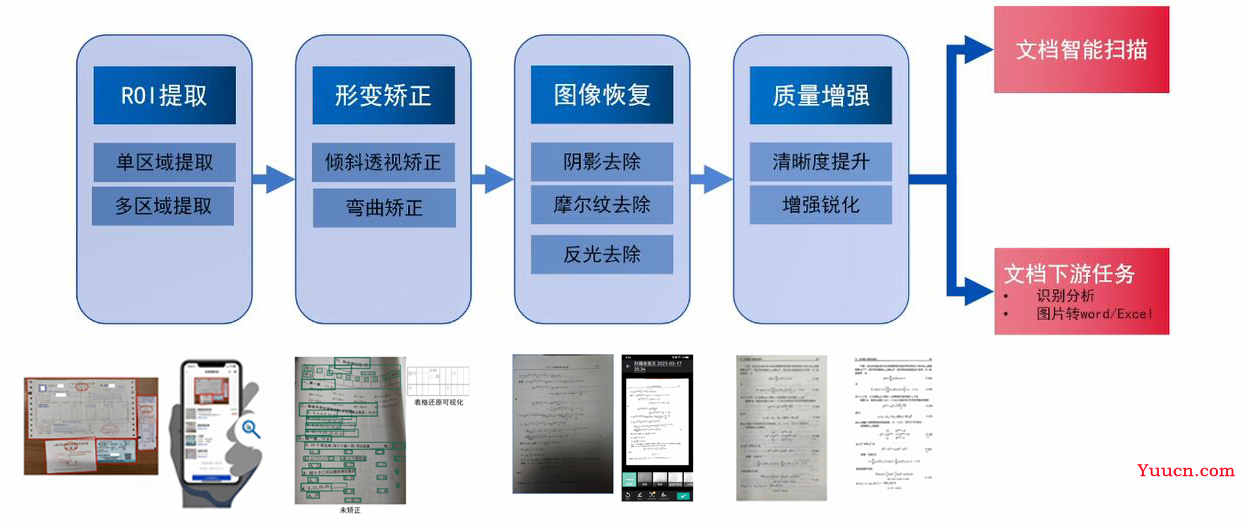

智能文档处理中,底层视觉处理的Pipeline流程主要包括以下几个步骤:

- ROI提取:在该步骤,图像中的关键区域被提取出来,以减少不相关区域对后续任务的干扰;

- 形变矫正:该步骤主要利用矫正方法对扭曲和倾斜的图像进行整平,为后续的OCR识别创造便利条件;

- 图像恢复:该步骤旨在消除阴影、反光、摩尔纹等干扰图像信息的噪声,从而提高图像的可识别程度;

- 质量增强:该步骤通过突出图像中的文本信息,有助于提高图像的可读性、可解释性和可感知质量。

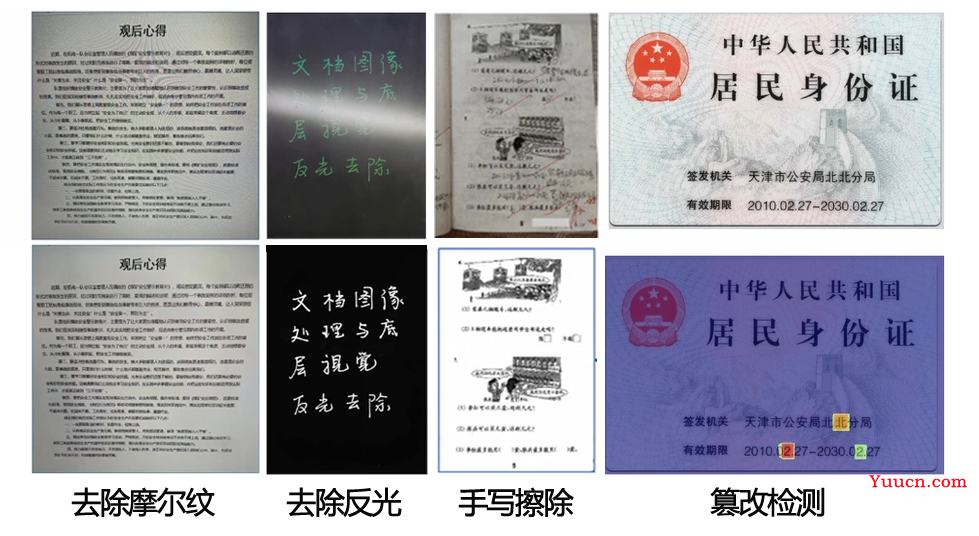

可以看出,底层视觉技术主要包括图像预处理、特征提取、边缘检测、形态学变换等。当前,底层视觉技术的前沿难点有去除摩尔纹、去除反光、手写擦除和篡改检测等等。

经过数年的技术积累,合合信息已经在智能文档处理领域沉淀了丰富的经验,并将这些技术集成到了“扫描全能王”应用和“TextIn (https://www.textin.com/)”平台上。

立足大模型,下一站在何方?

站在多模态和自然场景的角度上继续延伸,以ChatGPT为代表的对话式大语言模型的潜力还可以进一步开发。厦门大学南强特聘教授纪荣嵘从语言和视觉两个方面强调了打通各个模态之间壁垒的重要性。可以说,构建多模态模型是助力机器理解人类指令的重要踏板,以文本和图像为例,当文本信息和图像信息能够完全相互代表时,人类对于图像的操作就可以仅通过一段话来完成。

IDC发布的《2022中国大模型发展白皮书》中提到:面向未来,大模型必然成为重要的AI新型基础设施之一。任何依靠人工智能展开的研究都可以在这种生成式大模型的基础上得到发展。上海交通大学人工智能研究院常务副院长杨小康就认为,生成式人工智能为构建基于视觉直觉的物理世界模型和虚拟数字人提供了可行的途径。未来,随着数学、物理、信息论、脑认知、计算机等学科的交叉,还可以进一步夯实生成式人工智能的基础理论,实现“物理+数据”联合驱动、“虚拟+现实”深度融合,从而加速科学发现、物质合成以及世界模型的构建。

虽然通用人工智能的大门尚未完全叩开,但是我们已经看到了光明的前景,我们还有许多可以探索和实现的事物,山高水远,道阻且长。